Для оптимизации бота для Telegram на Python можно использовать следующие методы:

1. Асинхронность: Вместо синхронного выполнения запросов к API Telegram, можно использовать асинхронные библиотеки, такие как asyncio или aiohttp, чтобы выполнять запросы параллельно и увеличить скорость выполнения.

2. Кэширование: Если постоянно запрашивать одни и те же данные (например, информацию о канале), можно закешировать их, чтобы избежать повторных запросов к API.

3. Оптимизация запросов: Проверьте, можно ли объединить несколько запросов в один или уменьшить количество запросов, чтобы сократить время работы и нагрузку на ресурсы.

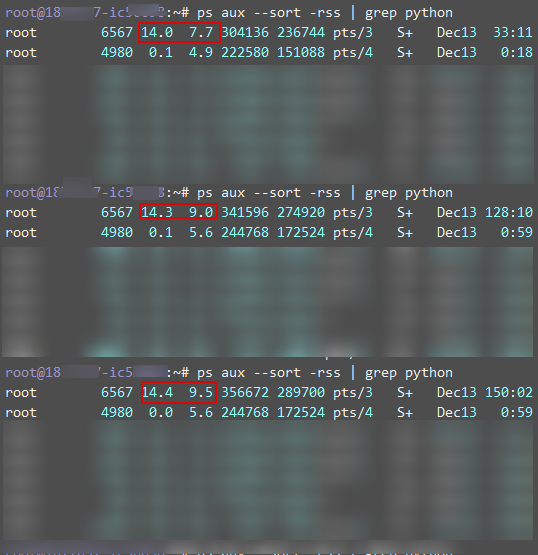

4. Управление памятью: Если ваш бот использует большое количество оперативной памяти, проверьте, есть ли утечки памяти или места, где память можно оптимизировать. Убедитесь, что вы не храните ненужные данные в памяти, особенно при обработке больших объемов данных.

5. Оптимизация хранения данных: Рассмотрите возможность хранить собранные ссылки непосредственно в базе данных или в файле, а не в оперативной памяти. Это позволит снизить потребление памяти и сохранить данные для долгосрочного использования.

6. Масштабирование: Если ваш бот имеет большую загрузку или выполняет сложные задачи, рассмотрите возможность масштабирования архитектуры, например, использование очередей сообщений или распределенные вычисления для обработки задач в параллель.

В случае сбора и обработки ссылок с YouTube канала вы можете использовать следующие подходы для оптимизации:

1. Используйте пакет google-api-python-client для работы с YouTube API. Он предоставляет эффективные методы запроса данных из API, что может уменьшить количество запросов и, следовательно, потребление ресурсов.

2. Используйте стратегию пагинации для получения данных постранично, вместо одного большого запроса за всеми данными сразу. Это позволит уменьшить нагрузку на ресурсы при обработке больших объемов данных.

3. Оптимизируйте обработку полученных данных, уделяя внимание выделению только необходимой информации и оптимизации алгоритмов обработки.

4. Если вам нужно сохранить собранные ссылки на долгосрочное хранение, рассмотрите возможность записи их непосредственно в файл или базу данных, а не хранение в оперативной памяти.

5. Проверьте, есть ли утечки памяти или проблемы с управлением памятью в вашем коде. Убедитесь, что вы правильно освобождаете память после использования.

6. Если процесс сбора ссылок требует большого количества оперативной памяти, рассмотрите возможность использования внешнего хранилища, такого как AWS S3 или Google Cloud Storage, для временного хранения собранных данных с минимизацией потребления локальной памяти.